数仓搭建-ODS层

数仓搭建-ODS层

# 数仓搭建 - ODS 层

# Hive 环境准备

# Hive on Spark 编译

下载 spark 源码 https://www.apache.org/dyn/closer.lua/spark/spark-2.4.5/spark-2.4.5.tgz

解压并执行编译命令

cd /opt/software

tar -zxvf spark-2.4.5.tgz -C /opt/module/

cd /opt/module/spark-2.4.5

./dev/make-distribution.sh --name without-hive --tgz -Pyarn -Phadoop-3.1 -Dhadoop.version=3.1.3 -Pparquet-provided -Porc-provided -Phadoop-provided

2

3

4

等待编译完成,spark-2.4.5-bin-without-hive.tgz 为最终文件

# Hive on Spark 配置

解压 spark-2.4.5-bin-without-hive.tgz

cd /opt/software

tar -zxf /opt/software/spark-2.4.5-bin-without-hive.tgz -C /opt/module

mv /opt/module/spark-2.4.5-bin-without-hive /opt/module/spark

2

3

配置 spark 环境变量

sudo vim /etc/profile.d/my_env.sh

添加如下内容

#SPARK_HOME

export SPARK_HOME=/opt/module/spark

export PATH=$PATH:$SPARK_HOME/bin

2

3

source 使其生效

source /etc/profile.d/my_env.sh

配置 spark 运行环境

mv /opt/module/spark/conf/spark-env.sh.template /opt/module/spark/conf/spark-env.sh

vim /opt/module/spark/conf/spark-env.sh

2

添加如下内容

export SPARK_DIST_CLASSPATH=$(hadoop classpath)

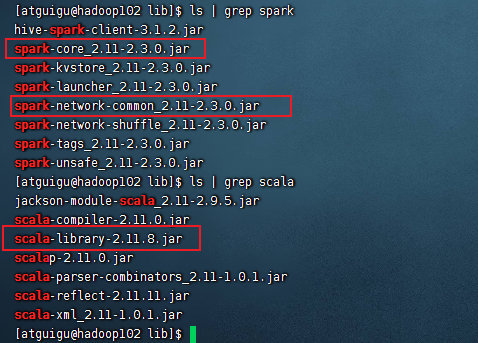

软连接 sparkjar 包到 hive,如何 hive 中已存在则跳过

ln -s /opt/module/spark/jars/scala-library-2.11.12.jar /opt/module/hive/lib/scala-library-2.11.12.jar

ln -s /opt/module/spark/jars/spark-core_2.11-2.4.5.jar /opt/module/hive/lib/spark-core_2.11-2.4.5.jar

ln -s /opt/module/spark/jars/spark-network-common_2.11-2.4.5.jar /opt/module/hive/lib/spark-network-common_2.11-2.4.5.jar

2

3

新建 spark-defaults.conf 配置文件

vim /opt/module/hive/conf/spark-defaults.conf

添加如下内容

spark.master yarn

spark.eventLog.enabled true

spark.eventLog.dir hdfs://hadoop102:8020/spark-history

spark.driver.memory 2g

spark.executor.memory 2g

2

3

4

5

在 HDFS 创建如下路径

hadoop fs -mkdir /spark-history

上传 Spark 依赖到 HDFS

hadoop fs -mkdir /spark-jars

hadoop fs -put /opt/module/spark/jars/* /spark-jars

2

修改 hive-site.xml

vim /opt/module/hive/conf/hive-site.xml

添加以下内容

<!--Spark依赖位置-->

<property>

<name>spark.yarn.jars</name>

<value>hdfs://hadoop102:8020/spark-jars/*</value>

</property>

<!--Hive执行引擎-->

<property>

<name>hive.execution.engine</name>

<value>spark</value>

</property>

2

3

4

5

6

7

8

9

10

11

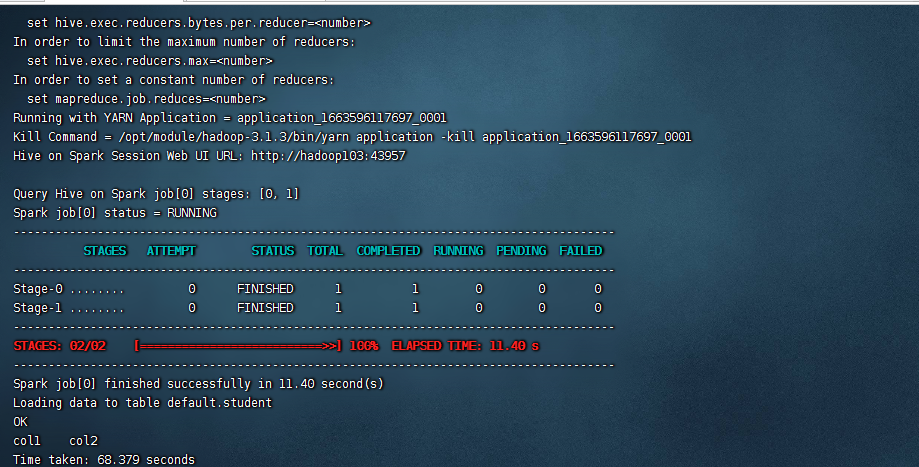

# Hive on Spark 测试

启动 hive 客户端

hiveservices.sh start

hive

2

创建一张测试表,通过 insert 测试效果

create external table student(id int, name string) location '/student';

insert into table student values(1,'abc');

2

查询是否插入成功

select * from student;

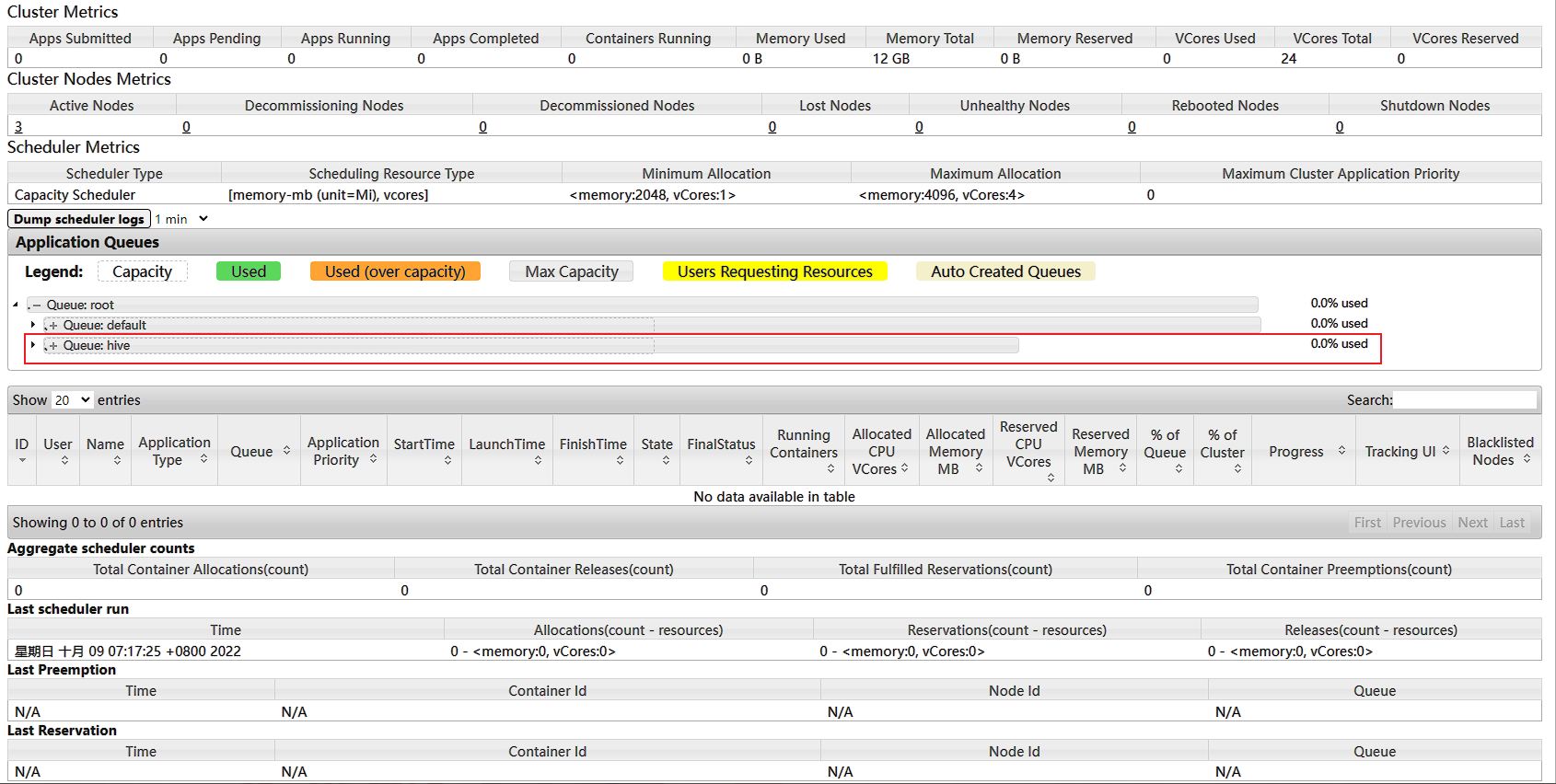

# Yarn 容量调度器队列配置

由于我们开启 Hive on Spark 时,不退出 Hive 客户端,会一直存在一个 job 不结束,这个 job 是 spark session 开启的,Hive 客户端退出则自动结束。但是由于这个 job 一直存在,导致其他 job 无法正常进行,因此我们需要为 hive 配置一个队列,进行多 job 处理。

增加 hive 队列,默认 Yarn 的配置下,容量调度器只有一条 Default 队列。

vim /opt/module/hadoop-3.1.3/etc/hadoop/capacity-scheduler.xml

在 capacity-scheduler.xml 中可以配置多条队列,修改以下属性,增加 hive 队列。

<property>

<name>yarn.scheduler.capacity.root.queues</name>

<value>default,hive</value>

<description>

The queues at the this level (root is the root queue).

</description>

</property>

<property>

<name>yarn.scheduler.capacity.root.default.capacity</name>

<value>50</value>

<description>

default队列的容量为50%

</description>

</property>

2

3

4

5

6

7

8

9

10

11

12

13

14

同时为新加队列添加必要属性:

<property>

<name>yarn.scheduler.capacity.root.hive.capacity</name>

<value>50</value>

<description>

hive队列的容量为50%

</description>

</property>

<property>

<name>yarn.scheduler.capacity.root.hive.user-limit-factor</name>

<value>1</value>

<description>

一个用户最多能够获取该队列资源容量的比例

</description>

</property>

<property>

<name>yarn.scheduler.capacity.root.hive.maximum-capacity</name>

<value>80</value>

<description>

hive队列的最大容量

</description>

</property>

<property>

<name>yarn.scheduler.capacity.root.hive.state</name>

<value>RUNNING</value>

</property>

<property>

<name>yarn.scheduler.capacity.root.hive.acl_submit_applications</name>

<value>*</value>

<description>

访问控制,控制谁可以将任务提交到该队列

</description>

</property>

<property>

<name>yarn.scheduler.capacity.root.hive.acl_administer_queue</name>

<value>*</value>

<description>

访问控制,控制谁可以管理(包括提交和取消)该队列的任务

</description>

</property>

<property>

<name>yarn.scheduler.capacity.root.hive.acl_application_max_priority</name>

<value>*</value>

<description>

访问控制,控制用户可以提交到该队列的任务的最大优先级

</description>

</property>

<property>

<name>yarn.scheduler.capacity.root.hive.maximum-application-lifetime</name>

<value>-1</value>

<description>

hive队列中任务的最大生命时长

</description>

</property>

<property>

<name>yarn.scheduler.capacity.root.hive.default-application-lifetime</name>

<value>-1</value>

<description>

default队列中任务的最大生命时长

</description>

</property>

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

同步到 hadoop103 机器上

xsync /opt/module/hadoop-3.1.3/etc/hadoop/capacity-scheduler.xml

进入 http://hadoop103:8088/cluster/scheduler 查看是否生效

配置 hive 客户端任务提交到 hive 队列

为方便后续 hive 客户端的测试和 shell 脚本中的任务能同时执行,我们将 hive 客户端的测试任务提交到 hive 队列,让 shell 脚本中的任务使用默认值,提交到 default 队列。

每次进入 hive 客户端时,执行以下命令

set mapreduce.job.queuename=hive;

# 数仓搭建 - ODS 层

- 保持数据原貌不做任何修改,起到备份数据的作用。

- 数据采用 LZO 压缩,减少磁盘存储空间。100G 数据可以压缩到 10G 以内。

- 创建分区表,防止后续的全表扫描,在企业开发中大量使用分区表。

- 创建外部表。在企业开发中,除了自己用的临时表,创建内部表外,绝大多数场景都是创建外部表。

# 创建日志数据

cluster.sh stop # 关闭集群

dt.sh 2020-03-10 # 修改集群时间

cluster.sh start # 启动集群

lg.sh # 生成日志文件

2

3

4

进入管理页面查看是否生成 lzo 压缩文件

http://hadoop102:9870/explorer.html#/origin_data/gmall/log/topic_event/2020-03-10

# 创建数据库

启动 hive

hiveservices.sh start

hive

2

创建数据库

show databases;

create database gmall;

use gmall;

2

3

# ODS 层(用户行为数据)

# 创建启动日志表 ods_start_log

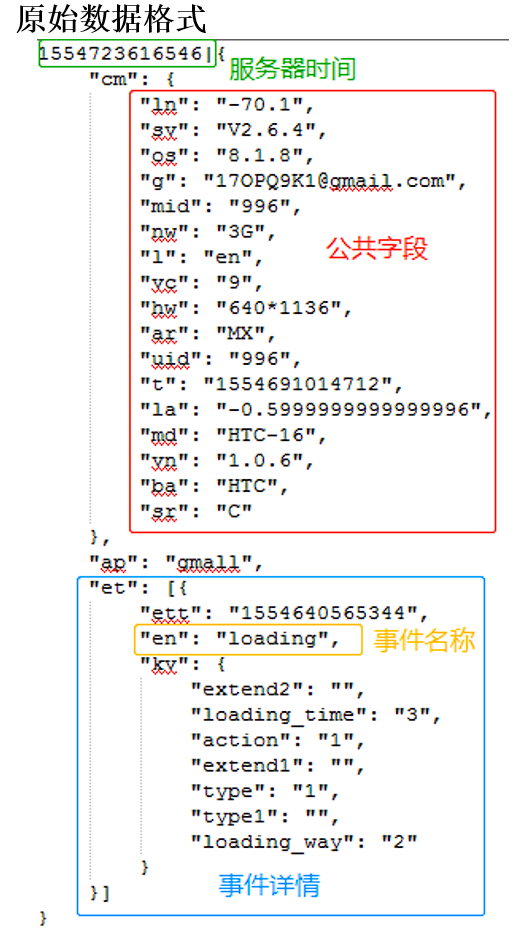

ODS 层创建启动日志表分析,原始日志数据格式。

{

"action": "1",

"ar": "MX",

"ba": "Huawei",

"detail": "325",

"en": "start",

"entry": "4",

"extend1": "",

"g": "[email protected]",

"hw": "1080*1920",

"l": "es",

"la": "-0.7",

"ln": "-42.9",

"loading_time": "9",

"md": "Huawei-0",

"mid": "995",

"nw": "3G",

"open_ad_type": "1",

"os": "8.0.9",

"sr": "F",

"sv": "V2.5.5",

"t": "1554653309882",

"uid": "995",

"vc": "1",

"vn": "1.3.1"

}

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

创建输入数据是 lzo 输出是 text,支持 json 解析的分区表

drop table if exists ods_start_log -- 如果创建的表已存在,先删除该表;

CREATE EXTERNAL TABLE ods_start_log (`line` string) -- 创建外部表

PARTITIONED BY (`dt` string) -- 按dt列即日期进行分区

STORED AS

INPUTFORMAT 'com.hadoop.mapred.DeprecatedLzoTextInputFormat'

OUTPUTFORMAT 'org.apache.hadoop.hive.ql.io.HiveIgnoreKeyTextOutputFormat' -- LZO 压缩格式处理

LOCATION '/warehouse/gmall/ods/ods_start_log' -- 数据存储位置;

2

3

4

5

6

7

说明 Hive 的 LZO 压缩:https://cwiki.apache.org/confluence/display/Hive/LanguageManual+LZO

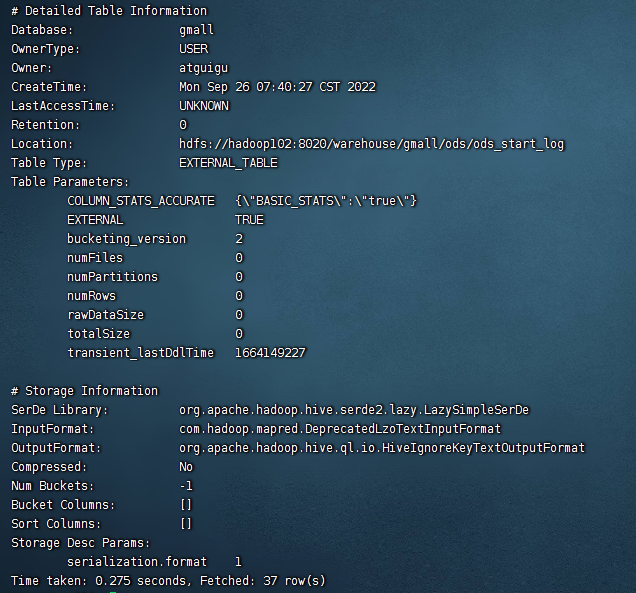

可以查看一下表详细结构

desc formatted ods_start_log;

加载数据

load data inpath '/origin_data/gmall/log/topic_start/2020-03-10' into table gmall.ods_start_log partition(dt='2020-03-10');

注意:时间格式都配置成 yyyy-MM-dd 格式,这是 Hive 默认支持的时间格式

查看是否加载成功

select * from ods_start_log limit 2;

为日志 lzo 压缩文件创建索引

hadoop jar /opt/module/hadoop-3.1.3/share/hadoop/common/hadoop-lzo-0.4.20.jar com.hadoop.compression.lzo.DistributedLzoIndexer /warehouse/gmall/ods/ods_start_log/dt=2020-03-10

# 创建事件日志表 ods_event_log

创建表

drop table if exists ods_event_log;

CREATE EXTERNAL TABLE ods_event_log(`line` string)

PARTITIONED BY (`dt` string)

STORED AS

INPUTFORMAT 'com.hadoop.mapred.DeprecatedLzoTextInputFormat'

OUTPUTFORMAT 'org.apache.hadoop.hive.ql.io.HiveIgnoreKeyTextOutputFormat'

LOCATION '/warehouse/gmall/ods/ods_event_log';

2

3

4

5

6

7

加载数据

load data inpath '/origin_data/gmall/log/topic_event/2020-03-10' into table gmall.ods_event_log partition(dt='2020-03-10');

select * from ods_event_log limit 2;

2

创建 lzo 索引

hadoop jar /opt/module/hadoop-3.1.3/share/hadoop/common/hadoop-lzo-0.4.20.jar com.hadoop.compression.lzo.DistributedLzoIndexer /warehouse/gmall/ods/ods_event_log/dt=2020-03-10

# Shell 中单引号和双引号区别

以具体例子演示

#!/bin/bash

do_date=$1

echo '$do_date'

echo "$do_date"

echo "'$do_date'"

echo '"$do_date"'

echo `date`

2

3

4

5

6

7

8

查看结果

$do_date

2020-03-10

'2020-03-10'

"$do_date"

2020年 05月 02日 星期四 21:02:08 CST

2

3

4

5

- 单引号不取变量值

- 双引号取变量值

- 反引号 `,执行引号中命令

- 双引号内部嵌套单引号,取出变量值

- 单引号内部嵌套双引号,不取出变量值

# ODS 层加载数据脚本

在 hadoop102 的 /home/atguigu/bin 目录下创建脚本

vim /home/atguigu/bin/hdfs_to_ods_log.sh

在脚本中编写如下内容

#!/bin/bash

db=gmall

hive=/opt/module/hive/bin/hive

do_date=`date -d '-1 day' +%F`

if [[ -n "$1" ]]; then

do_date=$1

fi

sql="

load data inpath '/origin_data/gmall/log/topic_start/$do_date' overwrite into table ${db}.ods_start_log partition(dt='$do_date');

load data inpath '/origin_data/gmall/log/topic_event/$do_date' overwrite into table ${db}.ods_event_log partition(dt='$do_date');

"

$hive -e "$sql"

hadoop jar /opt/module/hadoop-3.1.3/share/hadoop/common/hadoop-lzo-0.4.20.jar com.hadoop.compression.lzo.DistributedLzoIndexer /warehouse/gmall/ods/ods_start_log/dt=$do_date

hadoop jar /opt/module/hadoop-3.1.3/share/hadoop/common/hadoop-lzo-0.4.20.jar com.hadoop.compression.lzo.DistributedLzoIndexer /warehouse/gmall/ods/ods_event_log/dt=$do_date

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

[-n 变量值] 判断变量的值,是否为空

变量的值,非空,返回 true

变量的值,为空,返回 false

使用脚本

chmod +x /home/atguigu/bin/hdfs_to_ods_log.sh

lg.sh # 重新生成日志数据,因为上面创表时load已经加载过一次 删除了hdfs的日志数据

gmall_hdfs_to_ods_log.sh 2020-03-10

2

3

在 hive 中查看导入数据

use gmall;

select * from ods_start_log where dt='2020-03-10' limit 2;

select * from ods_event_log where dt='2020-03-10' limit 2;

2

3

企业开发中一般在每日凌晨 30 分~1 点

# ODS 层(业务数据)

# 创建 23 张业务表

-- 订单表(增量及更新)

drop table if exists ods_order_info;

create external table ods_order_info (

`id` string COMMENT '订单号',

`final_total_amount` decimal(10,2) COMMENT '订单金额',

`order_status` string COMMENT '订单状态',

`user_id` string COMMENT '用户id',

`out_trade_no` string COMMENT '支付流水号',

`create_time` string COMMENT '创建时间',

`operate_time` string COMMENT '操作时间',

`province_id` string COMMENT '省份ID',

`benefit_reduce_amount` decimal(10,2) COMMENT '优惠金额',

`original_total_amount` decimal(10,2) COMMENT '原价金额',

`feight_fee` decimal(10,2) COMMENT '运费'

) COMMENT '订单表'

PARTITIONED BY (`dt` string)

row format delimited fields terminated by '\t' -- 在hive中每列之间使用什么字符当分隔符存储

STORED AS

INPUTFORMAT 'com.hadoop.mapred.DeprecatedLzoTextInputFormat'

OUTPUTFORMAT 'org.apache.hadoop.hive.ql.io.HiveIgnoreKeyTextOutputFormat'

location '/warehouse/gmall/ods/ods_order_info/';

-- 订单详情表(增量)

drop table if exists ods_order_detail;

create external table ods_order_detail(

`id` string COMMENT '订单编号',

`order_id` string COMMENT '订单号',

`user_id` string COMMENT '用户id',

`sku_id` string COMMENT '商品id',

`sku_name` string COMMENT '商品名称',

`order_price` decimal(10,2) COMMENT '商品价格',

`sku_num` bigint COMMENT '商品数量',

`create_time` string COMMENT '创建时间'

) COMMENT '订单详情表'

PARTITIONED BY (`dt` string)

row format delimited fields terminated by '\t'

STORED AS

INPUTFORMAT 'com.hadoop.mapred.DeprecatedLzoTextInputFormat'

OUTPUTFORMAT 'org.apache.hadoop.hive.ql.io.HiveIgnoreKeyTextOutputFormat'

location '/warehouse/gmall/ods/ods_order_detail/';

-- SKU商品表(全量)

drop table if exists ods_sku_info;

create external table ods_sku_info(

`id` string COMMENT 'skuId',

`spu_id` string COMMENT 'spuid',

`price` decimal(10,2) COMMENT '价格',

`sku_name` string COMMENT '商品名称',

`sku_desc` string COMMENT '商品描述',

`weight` string COMMENT '重量',

`tm_id` string COMMENT '品牌id',

`category3_id` string COMMENT '品类id',

`create_time` string COMMENT '创建时间'

) COMMENT 'SKU商品表'

PARTITIONED BY (`dt` string)

row format delimited fields terminated by '\t'

STORED AS

INPUTFORMAT 'com.hadoop.mapred.DeprecatedLzoTextInputFormat'

OUTPUTFORMAT 'org.apache.hadoop.hive.ql.io.HiveIgnoreKeyTextOutputFormat'

location '/warehouse/gmall/ods/ods_sku_info/';

-- 用户表(增量及更新)

drop table if exists ods_user_info;

create external table ods_user_info(

`id` string COMMENT '用户id',

`name` string COMMENT '姓名',

`birthday` string COMMENT '生日',

`gender` string COMMENT '性别',

`email` string COMMENT '邮箱',

`user_level` string COMMENT '用户等级',

`create_time` string COMMENT '创建时间',

`operate_time` string COMMENT '操作时间'

) COMMENT '用户表'

PARTITIONED BY (`dt` string)

row format delimited fields terminated by '\t'

STORED AS

INPUTFORMAT 'com.hadoop.mapred.DeprecatedLzoTextInputFormat'

OUTPUTFORMAT 'org.apache.hadoop.hive.ql.io.HiveIgnoreKeyTextOutputFormat'

location '/warehouse/gmall/ods/ods_user_info/';

-- 商品一级分类表(全量)

drop table if exists ods_base_category1;

create external table ods_base_category1(

`id` string COMMENT 'id',

`name` string COMMENT '名称'

) COMMENT '商品一级分类表'

PARTITIONED BY (`dt` string)

row format delimited fields terminated by '\t'

STORED AS

INPUTFORMAT 'com.hadoop.mapred.DeprecatedLzoTextInputFormat'

OUTPUTFORMAT 'org.apache.hadoop.hive.ql.io.HiveIgnoreKeyTextOutputFormat'

location '/warehouse/gmall/ods/ods_base_category1/';

-- 商品二级分类表(全量)

drop table if exists ods_base_category2;

create external table ods_base_category2(

`id` string COMMENT ' id',

`name` string COMMENT '名称',

category1_id string COMMENT '一级品类id'

) COMMENT '商品二级分类表'

PARTITIONED BY (`dt` string)

row format delimited fields terminated by '\t'

STORED AS

INPUTFORMAT 'com.hadoop.mapred.DeprecatedLzoTextInputFormat'

OUTPUTFORMAT 'org.apache.hadoop.hive.ql.io.HiveIgnoreKeyTextOutputFormat'

location '/warehouse/gmall/ods/ods_base_category2/';

-- 商品三级分类表(全量)

drop table if exists ods_base_category3;

create external table ods_base_category3(

`id` string COMMENT ' id',

`name` string COMMENT '名称',

category2_id string COMMENT '二级品类id'

) COMMENT '商品三级分类表'

PARTITIONED BY (`dt` string)

row format delimited fields terminated by '\t'

STORED AS

INPUTFORMAT 'com.hadoop.mapred.DeprecatedLzoTextInputFormat'

OUTPUTFORMAT 'org.apache.hadoop.hive.ql.io.HiveIgnoreKeyTextOutputFormat'

location '/warehouse/gmall/ods/ods_base_category3/';

-- 支付流水表(增量)

drop table if exists ods_payment_info;

create external table ods_payment_info(

`id` bigint COMMENT '编号',

`out_trade_no` string COMMENT '对外业务编号',

`order_id` string COMMENT '订单编号',

`user_id` string COMMENT '用户编号',

`alipay_trade_no` string COMMENT '支付宝交易流水编号',

`total_amount` decimal(16,2) COMMENT '支付金额',

`subject` string COMMENT '交易内容',

`payment_type` string COMMENT '支付类型',

`payment_time` string COMMENT '支付时间'

) COMMENT '支付流水表'

PARTITIONED BY (`dt` string)

row format delimited fields terminated by '\t'

STORED AS

INPUTFORMAT 'com.hadoop.mapred.DeprecatedLzoTextInputFormat'

OUTPUTFORMAT 'org.apache.hadoop.hive.ql.io.HiveIgnoreKeyTextOutputFormat'

location '/warehouse/gmall/ods/ods_payment_info/';

-- 省份表(特殊)

drop table if exists ods_base_province;

create external table ods_base_province (

`id` bigint COMMENT '编号',

`name` string COMMENT '省份名称',

`region_id` string COMMENT '地区ID',

`area_code` string COMMENT '地区编码',

`iso_code` string COMMENT 'iso编码'

) COMMENT '省份表'

row format delimited fields terminated by '\t'

STORED AS

INPUTFORMAT 'com.hadoop.mapred.DeprecatedLzoTextInputFormat'

OUTPUTFORMAT 'org.apache.hadoop.hive.ql.io.HiveIgnoreKeyTextOutputFormat'

location '/warehouse/gmall/ods/ods_base_province/';

-- 地区表(特殊)

drop table if exists ods_base_region;

create external table ods_base_region (

`id` bigint COMMENT '编号',

`region_name` string COMMENT '地区名称'

) COMMENT '地区表'

row format delimited fields terminated by '\t'

STORED AS

INPUTFORMAT 'com.hadoop.mapred.DeprecatedLzoTextInputFormat'

OUTPUTFORMAT 'org.apache.hadoop.hive.ql.io.HiveIgnoreKeyTextOutputFormat'

location '/warehouse/gmall/ods/ods_base_region/';

-- 品牌表(全量)

drop table if exists ods_base_trademark;

create external table ods_base_trademark (

`tm_id` bigint COMMENT '编号',

`tm_name` string COMMENT '品牌名称'

) COMMENT '品牌表'

PARTITIONED BY (`dt` string)

row format delimited fields terminated by '\t'

STORED AS

INPUTFORMAT 'com.hadoop.mapred.DeprecatedLzoTextInputFormat'

OUTPUTFORMAT 'org.apache.hadoop.hive.ql.io.HiveIgnoreKeyTextOutputFormat'

location '/warehouse/gmall/ods/ods_base_trademark/';

-- 订单状态表(增量)

drop table if exists ods_order_status_log;

create external table ods_order_status_log (

`id` bigint COMMENT '编号',

`order_id` string COMMENT '订单ID',

`order_status` string COMMENT '订单状态',

`operate_time` string COMMENT '修改时间'

) COMMENT '订单状态表'

PARTITIONED BY (`dt` string)

row format delimited fields terminated by '\t'

STORED AS

INPUTFORMAT 'com.hadoop.mapred.DeprecatedLzoTextInputFormat'

OUTPUTFORMAT 'org.apache.hadoop.hive.ql.io.HiveIgnoreKeyTextOutputFormat'

location '/warehouse/gmall/ods/ods_order_status_log/';

-- SPU商品表(全量)

drop table if exists ods_spu_info;

create external table ods_spu_info(

`id` string COMMENT 'spuid',

`spu_name` string COMMENT 'spu名称',

`category3_id` string COMMENT '品类id',

`tm_id` string COMMENT '品牌id'

) COMMENT 'SPU商品表'

PARTITIONED BY (`dt` string)

row format delimited fields terminated by '\t'

STORED AS

INPUTFORMAT 'com.hadoop.mapred.DeprecatedLzoTextInputFormat'

OUTPUTFORMAT 'org.apache.hadoop.hive.ql.io.HiveIgnoreKeyTextOutputFormat'

location '/warehouse/gmall/ods/ods_spu_info/';

-- 商品评论表(增量)

drop table if exists ods_comment_info;

create external table ods_comment_info(

`id` string COMMENT '编号',

`user_id` string COMMENT '用户ID',

`sku_id` string COMMENT '商品sku',

`spu_id` string COMMENT '商品spu',

`order_id` string COMMENT '订单ID',

`appraise` string COMMENT '评价',

`create_time` string COMMENT '评价时间'

) COMMENT '商品评论表'

PARTITIONED BY (`dt` string)

row format delimited fields terminated by '\t'

STORED AS

INPUTFORMAT 'com.hadoop.mapred.DeprecatedLzoTextInputFormat'

OUTPUTFORMAT 'org.apache.hadoop.hive.ql.io.HiveIgnoreKeyTextOutputFormat'

location '/warehouse/gmall/ods/ods_comment_info/';

-- 退单表(增量)

drop table if exists ods_order_refund_info;

create external table ods_order_refund_info(

`id` string COMMENT '编号',

`user_id` string COMMENT '用户ID',

`order_id` string COMMENT '订单ID',

`sku_id` string COMMENT '商品ID',

`refund_type` string COMMENT '退款类型',

`refund_num` bigint COMMENT '退款件数',

`refund_amount` decimal(16,2) COMMENT '退款金额',

`refund_reason_type` string COMMENT '退款原因类型',

`create_time` string COMMENT '退款时间'

) COMMENT '退单表'

PARTITIONED BY (`dt` string)

row format delimited fields terminated by '\t'

STORED AS

INPUTFORMAT 'com.hadoop.mapred.DeprecatedLzoTextInputFormat'

OUTPUTFORMAT 'org.apache.hadoop.hive.ql.io.HiveIgnoreKeyTextOutputFormat'

location '/warehouse/gmall/ods/ods_order_refund_info/';

-- 加购表(全量)

drop table if exists ods_cart_info;

create external table ods_cart_info(

`id` string COMMENT '编号',

`user_id` string COMMENT '用户id',

`sku_id` string COMMENT 'skuid',

`cart_price` string COMMENT '放入购物车时价格',

`sku_num` string COMMENT '数量',

`sku_name` string COMMENT 'sku名称 (冗余)',

`create_time` string COMMENT '创建时间',

`operate_time` string COMMENT '修改时间',

`is_ordered` string COMMENT '是否已经下单',

`order_time` string COMMENT '下单时间'

) COMMENT '加购表'

PARTITIONED BY (`dt` string)

row format delimited fields terminated by '\t'

STORED AS

INPUTFORMAT 'com.hadoop.mapred.DeprecatedLzoTextInputFormat'

OUTPUTFORMAT 'org.apache.hadoop.hive.ql.io.HiveIgnoreKeyTextOutputFormat'

location '/warehouse/gmall/ods/ods_cart_info/';

-- 商品收藏表(全量)

drop table if exists ods_favor_info;

create external table ods_favor_info(

`id` string COMMENT '编号',

`user_id` string COMMENT '用户id',

`sku_id` string COMMENT 'skuid',

`spu_id` string COMMENT 'spuid',

`is_cancel` string COMMENT '是否取消',

`create_time` string COMMENT '收藏时间',

`cancel_time` string COMMENT '取消时间'

) COMMENT '商品收藏表'

PARTITIONED BY (`dt` string)

row format delimited fields terminated by '\t'

STORED AS

INPUTFORMAT 'com.hadoop.mapred.DeprecatedLzoTextInputFormat'

OUTPUTFORMAT 'org.apache.hadoop.hive.ql.io.HiveIgnoreKeyTextOutputFormat'

location '/warehouse/gmall/ods/ods_favor_info/';

-- 优惠券领用表(新增及变化)

drop table if exists ods_coupon_use;

create external table ods_coupon_use(

`id` string COMMENT '编号',

`coupon_id` string COMMENT '优惠券ID',

`user_id` string COMMENT 'skuid',

`order_id` string COMMENT 'spuid',

`coupon_status` string COMMENT '优惠券状态',

`get_time` string COMMENT '领取时间',

`using_time` string COMMENT '使用时间(下单)',

`used_time` string COMMENT '使用时间(支付)'

) COMMENT '优惠券领用表'

PARTITIONED BY (`dt` string)

row format delimited fields terminated by '\t'

STORED AS

INPUTFORMAT 'com.hadoop.mapred.DeprecatedLzoTextInputFormat'

OUTPUTFORMAT 'org.apache.hadoop.hive.ql.io.HiveIgnoreKeyTextOutputFormat'

location '/warehouse/gmall/ods/ods_coupon_use/';

-- 优惠券表(全量)

drop table if exists ods_coupon_info;

create external table ods_coupon_info(

`id` string COMMENT '购物券编号',

`coupon_name` string COMMENT '购物券名称',

`coupon_type` string COMMENT '购物券类型 1 现金券 2 折扣券 3 满减券 4 满件打折券',

`condition_amount` string COMMENT '满额数',

`condition_num` string COMMENT '满件数',

`activity_id` string COMMENT '活动编号',

`benefit_amount` string COMMENT '减金额',

`benefit_discount` string COMMENT '折扣',

`create_time` string COMMENT '创建时间',

`range_type` string COMMENT '范围类型 1、商品 2、品类 3、品牌',

`spu_id` string COMMENT '商品id',

`tm_id` string COMMENT '品牌id',

`category3_id` string COMMENT '品类id',

`limit_num` string COMMENT '最多领用次数',

`operate_time` string COMMENT '修改时间',

`expire_time` string COMMENT '过期时间'

) COMMENT '优惠券表'

PARTITIONED BY (`dt` string)

row format delimited fields terminated by '\t'

STORED AS

INPUTFORMAT 'com.hadoop.mapred.DeprecatedLzoTextInputFormat'

OUTPUTFORMAT 'org.apache.hadoop.hive.ql.io.HiveIgnoreKeyTextOutputFormat'

location '/warehouse/gmall/ods/ods_coupon_info/';

-- 活动表(全量)

drop table if exists ods_activity_info;

create external table ods_activity_info(

`id` string COMMENT '编号',

`activity_name` string COMMENT '活动名称',

`activity_type` string COMMENT '活动类型',

`start_time` string COMMENT '开始时间',

`end_time` string COMMENT '结束时间',

`create_time` string COMMENT '创建时间'

) COMMENT '活动表'

PARTITIONED BY (`dt` string)

row format delimited fields terminated by '\t'

STORED AS

INPUTFORMAT 'com.hadoop.mapred.DeprecatedLzoTextInputFormat'

OUTPUTFORMAT 'org.apache.hadoop.hive.ql.io.HiveIgnoreKeyTextOutputFormat'

location '/warehouse/gmall/ods/ods_activity_info/';

-- 活动订单关联表(增量)

drop table if exists ods_activity_order;

create external table ods_activity_order(

`id` string COMMENT '编号',

`activity_id` string COMMENT '优惠券ID',

`order_id` string COMMENT 'skuid',

`create_time` string COMMENT '领取时间'

) COMMENT '活动订单关联表'

PARTITIONED BY (`dt` string)

row format delimited fields terminated by '\t'

STORED AS

INPUTFORMAT 'com.hadoop.mapred.DeprecatedLzoTextInputFormat'

OUTPUTFORMAT 'org.apache.hadoop.hive.ql.io.HiveIgnoreKeyTextOutputFormat'

location '/warehouse/gmall/ods/ods_activity_order/';

-- 活动规则表(全量)

drop table if exists ods_activity_rule;

create external table ods_activity_rule(

`id` string COMMENT '编号',

`activity_id` string COMMENT '活动ID',

`condition_amount` string COMMENT '满减金额',

`condition_num` string COMMENT '满减件数',

`benefit_amount` string COMMENT '优惠金额',

`benefit_discount` string COMMENT '优惠折扣',

`benefit_level` string COMMENT '优惠级别'

) COMMENT '优惠规则表'

PARTITIONED BY (`dt` string)

row format delimited fields terminated by '\t'

STORED AS

INPUTFORMAT 'com.hadoop.mapred.DeprecatedLzoTextInputFormat'

OUTPUTFORMAT 'org.apache.hadoop.hive.ql.io.HiveIgnoreKeyTextOutputFormat'

location '/warehouse/gmall/ods/ods_activity_rule/';

-- 编码字典表(全量)

drop table if exists ods_base_dic;

create external table ods_base_dic(

`dic_code` string COMMENT '编号',

`dic_name` string COMMENT '编码名称',

`parent_code` string COMMENT '父编码',

`create_time` string COMMENT '创建日期',

`operate_time` string COMMENT '操作日期'

) COMMENT '编码字典表'

PARTITIONED BY (`dt` string)

row format delimited fields terminated by '\t'

STORED AS

INPUTFORMAT 'com.hadoop.mapred.DeprecatedLzoTextInputFormat'

OUTPUTFORMAT 'org.apache.hadoop.hive.ql.io.HiveIgnoreKeyTextOutputFormat'

location '/warehouse/gmall/ods/ods_base_dic/';

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81

82

83

84

85

86

87

88

89

90

91

92

93

94

95

96

97

98

99

100

101

102

103

104

105

106

107

108

109

110

111

112

113

114

115

116

117

118

119

120

121

122

123

124

125

126

127

128

129

130

131

132

133

134

135

136

137

138

139

140

141

142

143

144

145

146

147

148

149

150

151

152

153

154

155

156

157

158

159

160

161

162

163

164

165

166

167

168

169

170

171

172

173

174

175

176

177

178

179

180

181

182

183

184

185

186

187

188

189

190

191

192

193

194

195

196

197

198

199

200

201

202

203

204

205

206

207

208

209

210

211

212

213

214

215

216

217

218

219

220

221

222

223

224

225

226

227

228

229

230

231

232

233

234

235

236

237

238

239

240

241

242

243

244

245

246

247

248

249

250

251

252

253

254

255

256

257

258

259

260

261

262

263

264

265

266

267

268

269

270

271

272

273

274

275

276

277

278

279

280

281

282

283

284

285

286

287

288

289

290

291

292

293

294

295

296

297

298

299

300

301

302

303

304

305

306

307

308

309

310

311

312

313

314

315

316

317

318

319

320

321

322

323

324

325

326

327

328

329

330

331

332

333

334

335

336

337

338

339

340

341

342

343

344

345

346

347

348

349

350

351

352

353

354

355

356

357

358

359

360

361

362

363

364

365

366

367

368

369

370

371

372

373

374

375

376

377

378

379

380

381

382

383

384

385

386

387

388

389

390

391

392

393

394

395

396

397

398

399

查看 23 张表是否建立成功,连上两张日志表一共 25 张表

show tables;

ods_activity_info

ods_activity_order

ods_activity_rule

ods_base_category1

ods_base_category2

ods_base_category3

ods_base_dic

ods_base_province

ods_base_region

ods_base_trademark

ods_cart_info

ods_comment_info

ods_coupon_info

ods_coupon_use

ods_event_log # 日志表

ods_favor_info

ods_order_detail

ods_order_info

ods_order_refund_info

ods_order_status_log

ods_payment_info

ods_sku_info

ods_spu_info

ods_start_log # 日志表

ods_user_info

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

# ODS 层加载数据脚本

在 /home/atguigu/bin 目录下创建脚本 hdfs_to_ods_db.sh

vim /home/atguigu/bin/hdfs_to_ods_db.sh

在脚本中填写如下内容

#!/bin/bash

APP=gmall

hive=/opt/module/hive/bin/hive

# 如果是输入的日期按照取输入日期;如果没输入日期取当前时间的前一天

if [ -n "$2" ] ;then

do_date=$2

else

do_date=`date -d "-1 day" +%F`

fi

sql1="

load data inpath '/origin_data/$APP/db/order_info/$do_date' OVERWRITE into table ${APP}.ods_order_info partition(dt='$do_date');

load data inpath '/origin_data/$APP/db/order_detail/$do_date' OVERWRITE into table ${APP}.ods_order_detail partition(dt='$do_date');

load data inpath '/origin_data/$APP/db/sku_info/$do_date' OVERWRITE into table ${APP}.ods_sku_info partition(dt='$do_date');

load data inpath '/origin_data/$APP/db/user_info/$do_date' OVERWRITE into table ${APP}.ods_user_info partition(dt='$do_date');

load data inpath '/origin_data/$APP/db/payment_info/$do_date' OVERWRITE into table ${APP}.ods_payment_info partition(dt='$do_date');

load data inpath '/origin_data/$APP/db/base_category1/$do_date' OVERWRITE into table ${APP}.ods_base_category1 partition(dt='$do_date');

load data inpath '/origin_data/$APP/db/base_category2/$do_date' OVERWRITE into table ${APP}.ods_base_category2 partition(dt='$do_date');

load data inpath '/origin_data/$APP/db/base_category3/$do_date' OVERWRITE into table ${APP}.ods_base_category3 partition(dt='$do_date');

load data inpath '/origin_data/$APP/db/base_trademark/$do_date' OVERWRITE into table ${APP}.ods_base_trademark partition(dt='$do_date');

load data inpath '/origin_data/$APP/db/activity_info/$do_date' OVERWRITE into table ${APP}.ods_activity_info partition(dt='$do_date');

load data inpath '/origin_data/$APP/db/activity_order/$do_date' OVERWRITE into table ${APP}.ods_activity_order partition(dt='$do_date');

load data inpath '/origin_data/$APP/db/cart_info/$do_date' OVERWRITE into table ${APP}.ods_cart_info partition(dt='$do_date');

load data inpath '/origin_data/$APP/db/comment_info/$do_date' OVERWRITE into table ${APP}.ods_comment_info partition(dt='$do_date');

load data inpath '/origin_data/$APP/db/coupon_info/$do_date' OVERWRITE into table ${APP}.ods_coupon_info partition(dt='$do_date');

load data inpath '/origin_data/$APP/db/coupon_use/$do_date' OVERWRITE into table ${APP}.ods_coupon_use partition(dt='$do_date');

load data inpath '/origin_data/$APP/db/favor_info/$do_date' OVERWRITE into table ${APP}.ods_favor_info partition(dt='$do_date');

load data inpath '/origin_data/$APP/db/order_refund_info/$do_date' OVERWRITE into table ${APP}.ods_order_refund_info partition(dt='$do_date');

load data inpath '/origin_data/$APP/db/order_status_log/$do_date' OVERWRITE into table ${APP}.ods_order_status_log partition(dt='$do_date');

load data inpath '/origin_data/$APP/db/spu_info/$do_date' OVERWRITE into table ${APP}.ods_spu_info partition(dt='$do_date');

load data inpath '/origin_data/$APP/db/activity_rule/$do_date' OVERWRITE into table ${APP}.ods_activity_rule partition(dt='$do_date');

load data inpath '/origin_data/$APP/db/base_dic/$do_date' OVERWRITE into table ${APP}.ods_base_dic partition(dt='$do_date');

"

sql2="

load data inpath '/origin_data/$APP/db/base_province/$do_date' OVERWRITE into table ${APP}.ods_base_province;

load data inpath '/origin_data/$APP/db/base_region/$do_date' OVERWRITE into table ${APP}.ods_base_region;

"

case $1 in

"first"){

$hive -e "$sql1$sql2"

};;

"all"){

$hive -e "$sql1"

};;

esac

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

执行脚本

chmod +x /home/atguigu/bin/hdfs_to_ods_db.sh

hdfs_to_ods_db.sh first 2020-03-10 # 初次导入

2

以后每日导入可以不用使用全量导入,使用 all 模式。

hdfs_to_ods_db.sh all 2020-03-11

测试数据是否导入成功

use gmall;

select * from ods_order_detail where dt='2020-03-10';

2