数据持久化

数据持久化

# 数据持久化

kubernetes 集群不会为你处理数据的存储,我们可以为数据库挂载一个磁盘来确保数据的安全。

Volume 是 Pod 中能够被多个容器访问的共享目录。Kubernetes 的 Volume 定义在 Pod 上,它被一个 Pod 中的多个容 器挂载到具体的文件目录下。Volume 与 Pod 的生命周期相同,但与容器的生命周期不相关,当容器终止或重启时,Volume 中的数据也不会丢失。

Kubernetes 支持多种类型的 Volume, 包括:emptyDir、hostPath、gcePersistentDisk、awsElasticBlockStore、nfs、iscsi、flocker、glusterfs、rbd、cephfs、gitRepo、secret、persistentVolumeClaim、downwardAPI、azureFileVolume、azureDisk、vsphereVolume、Quobyte、PortworxVolume、ScaleIO。emptyDirEmptyDir 类型的 volume 创建于 pod 被调度到某个宿主机上的时候,而同一个 pod 内的容器都能读写 EmptyDir 中的同一个文件。一旦这个 pod 离开了这个宿主机,EmptyDir 中的数据就会被永久删除。所以目前 EmptyDir 类型的 volume 主要用作临时空间,比如 Web 服务器写日志或者 tmp 文件需要的临时目录。

你可以选择云存储、本地磁盘、NFS。

- 本地磁盘:可以挂载某个节点上的目录,但是这需要限定 pod 在这个节点上运行

- 云存储:不限定节点,不受集群影响,安全稳定;需要云服务商提供,裸机集群是没有的。

- NFS:不限定节点,不受集群影响

# hostPath 挂载示例

把节点上的一个目录挂载到 Pod,但是已经不推荐使用了,文档 (opens new window) 配置方式简单,需要手动指定 Pod 跑在某个固定的节点。 仅供单节点测试使用;不适用于多节点集群。

HostPath 属性的 volume 使得对应的容器能够访问当前宿主机上的指定目录。一旦这个 pod 离开了这个宿主机,HostDir 中的数据虽然不会被永久删除,但数据也不会随 pod 迁移到其他宿主机上。

minikube 提供了 hostPath 存储,文档 (opens new window)

apiVersion: apps/v1

kind: StatefulSet

metadata:

name: mongodb

spec:

replicas: 1

selector:

matchLabels:

app: mongodb

template:

metadata:

labels:

app: mongodb

spec:

containers:

- name: mongo

image: mongo:4.4

# IfNotPresent 仅本地没有镜像时才远程拉,Always 永远都是从远程拉,Never 永远只用本地镜像,本地没有则报错

imagePullPolicy: IfNotPresent

volumeMounts:

- mountPath: /data/db # 容器里面的挂载路径

name: mongo-data # 卷名字,必须跟下面定义的名字一致

volumes:

- name: mongo-data # 卷名字

hostPath:

path: /data/mongo-data # 节点上的路径

type: DirectoryOrCreate # 指向一个目录,不存在时自动创建

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

# NFS

NFS 类型 volume。允许一块现有的网络硬盘在同一个 pod 内的容器间共享。

#所有机器安装

yum install -y nfs-utils

2

主节点

#nfs主节点

echo "/nfs/data/ *(insecure,rw,sync,no_root_squash)" > /etc/exports

mkdir -p /nfs/data

systemctl enable rpcbind --now

systemctl enable nfs-server --now

#配置生效

exportfs -r

2

3

4

5

6

7

8

从节点

showmount -e 172.31.0.4 # 挂载主节点的nfs

#执行以下命令挂载 nfs 服务器上的共享目录到本机路径 /root/nfsmount

mkdir -p /nfs/data

mount -t nfs 172.31.0.4:/nfs/data /nfs/data

# 写入一个测试文件

echo "hello nfs server" > /nfs/data/test.txt

2

3

4

5

6

7

8

pod 直接挂载 nfs

apiVersion: apps/v1

kind: Deployment

metadata:

name: redis

spec:

selector:

matchLabels:

app: redis

revisionHistoryLimit: 2

template:

metadata:

labels:

app: redis

spec:

containers:

- image: redis

name: redis

imagePullPolicy: IfNotPresent

ports:

# 应用的内部端口

- containerPort: 6379

name: redis6379

env:

- name: ALLOW_EMPTY_PASSWORD

value: "yes"

- name: REDIS_PASSWORD

value: "redis"

volumeMounts:

# 持久化挂接位置,在 docker 中

- name: redis-persistent-storage

mountPath: /data

volumes:

- name: redis-persistent-storage

# 宿主机上的目录

nfs:

path: /k8s-nfs/redis/data

server: 192.168.126.112

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

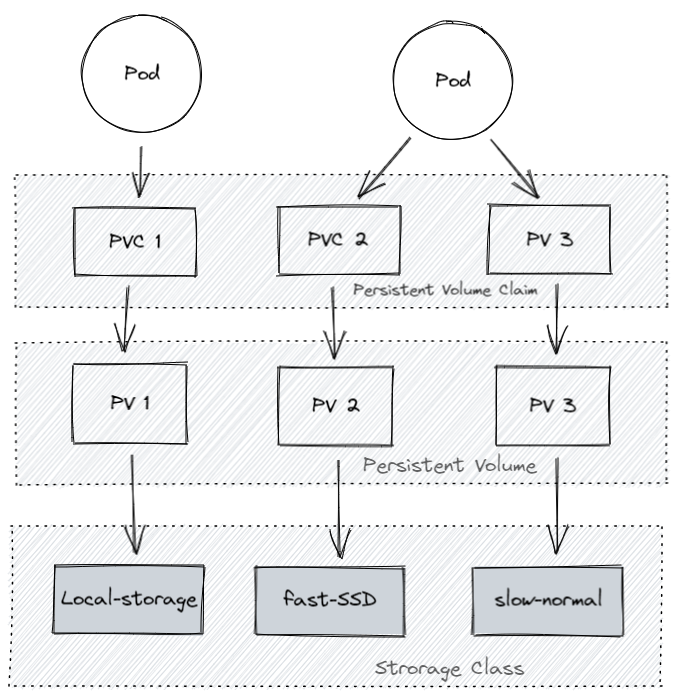

# 更高级的抽象

k8s 将数据卷分三层

- 声明卷容量和类型

- 描述卷的具体信息

- 将卷分为不同的类型

# Persistent Volume Claim (PVC)

PersistentVolumeClaim(PVC)是由用户进行存储的请求。 它类似于 pod。 Pod 消耗节点资源,PVC 消耗 PV 资源。Pod 可以请求特定级别的资源(CPU 和内存)。声明可以请求特定的大小和访问模式(例如,可以一次读 / 写或多次只读)。

对存储需求的一个申明,可以理解为一个申请单,系统根据这个申请单去找一个合适的 PV 还可以根据 PVC 自动创建 PV。

apiVersion: v1

kind: PersistentVolumeClaim

metadata:

name: mongodata

spec:

accessModes: ["ReadWriteOnce"]

storageClassName: "local-storage" # 绑定指定pvc

resources:

requests:

storage: 2Gi

2

3

4

5

6

7

8

9

10

kubectl apply -f pvc-demo.yaml

kubectl get pvc

2

创建 Pod 绑定 PVC

apiVersion: apps/v1

kind: Deployment

metadata:

labels:

app: nginx-deploy-pvc

name: nginx-deploy-pvc

spec:

replicas: 2

selector:

matchLabels:

app: nginx-deploy-pvc

template:

metadata:

labels:

app: nginx-deploy-pvc

spec:

containers:

- image: nginx

name: nginx

volumeMounts:

- name: html

mountPath: /usr/share/nginx/html

volumes:

- name: html

persistentVolumeClaim:

claimName: mongodata # pvc的name

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

# Persistent Volume (PV)

PersistentVolume(PV)是集群中由管理员配置的一段网络存储。 它是集群中的资源,就像节点是集群资源一样。 PV 是容量插件,如 Volumes,但其生命周期独立于使用 PV 的任何单个 pod。 此 API 对象捕获存储实现的详细信息,包括 NFS,iSCSI 或特定于云提供程序的存储系统。

PVC 和 PV 是一一对应的。

描述卷的具体信息,例如磁盘大小,访问模式 (opens new window)。文档 (opens new window),类型 (opens new window),Local 示例 (opens new window)

apiVersion: v1

kind: PersistentVolume

metadata:

name: mongodata

spec:

capacity:

storage: 2Gi

volumeMode: Filesystem # Filesystem(文件系统) Block(块)

accessModes:

- ReadWriteOnce # 卷可以被一个节点以读写方式挂载

persistentVolumeReclaimPolicy: Delete

storageClassName: local-storage # 自定义的存储类名称

local:

path: /root/data

nodeAffinity:

required:

# 通过 hostname 限定在某个节点创建存储卷

nodeSelectorTerms:

- matchExpressions:

- key: kubernetes.io/hostname

operator: In

values:

- node2

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

kubectl apply -f pv-demo.yaml

kubectl get pv

2

# PV 卷阶段状态

- Available – 资源尚未被 claim 使用

- Bound – 卷已经被绑定到 claim 了

- Released – claim 被删除,卷处于释放状态,但未被集群回收。

- Failed – 卷自动回收失败

# Storage Class (SC)

虽然 PersistentVolumeClaims 允许用户使用抽象存储资源,但是 PersistentVolumes 对于不同的问题,用户通常需要具有不同属性(例如性能)。群集管理员需要能够提供各种 PersistentVolumes 不同的方式,而不仅仅是大小和访问模式,而不会让用户了解这些卷的实现方式。对于这些需求,有 StorageClass 资源。

StorageClass 为管理员提供了一种描述他们提供的存储的 “类” 的方法。 不同的类可能映射到服务质量级别,或备份策略,或者由群集管理员确定的任意策略。 Kubernetes 本身对于什么类别代表是不言而喻的。 这个概念有时在其他存储系统中称为 “配置文件”。

将存储卷划分为不同的种类,例如:SSD,普通磁盘,本地磁盘,按需使用。文档 (opens new window)

apiVersion: storage.k8s.io/v1

kind: StorageClass

metadata:

name: slow

provisioner: kubernetes.io/aws-ebs

parameters:

type: io1

iopsPerGB: "10"

fsType: ext4

2

3

4

5

6

7

8

9

# 生命周期

PV 是群集中的资源。PVC 是对这些资源的请求,并且还充当对资源的检查。PV 和 PVC 之间的相互作用遵循以下生命周期:

Provisioning ——> Binding ——– > Using —— > Releasing —— > Recycling

供应准备 Provisioning--- 通过集群外的存储系统或者云平台来提供存储持久化支持。

静态提供 Static:集群管理员创建多个 PV。 它们携带可供集群用户使用的真实存储的详细信息。 它们存在于 Kubernetes API 中,可用于消费

动态提供 Dynamic:当管理员创建的静态 PV 都不匹配用户的 PersistentVolumeClaim 时,集群可能会尝试为 PVC 动态配置卷。 此配置基于 StorageClasses:PVC 必须请求一个类,并且管理员必须已创建并配置该类才能进行动态配置。 要求该类的声明有效地为自己禁用动态配置。

绑定 Binding--- 用户创建 pvc 并指定需要的资源和访问模式。在找到可用 pv 之前,pvc 会保持未绑定状态。

使用 Using--- 用户可在 pod 中像 volume 一样使用 pvc。

释放 Releasing--- 用户删除 pvc 来回收存储资源,pv 将变成 “released” 状态。由于还保留着之前的数据,这些数据需要根据不同的策略来处理,否则这些存储资源无法被其他 pvc 使用。

回收 Recycling---pv 可以设置三种回收策略:保留(Retain),回收(Recycle)和删除(Delete)。

- 保留策略:允许人工处理保留的数据。

- 删除策略:将删除 pv 和外部关联的存储资源,需要插件支持。

- 回收策略:将执行清除操作,之后可以被新的 pvc 使用,需要插件支持

# 为什么要这么多层抽象

- 更好的分工,运维人员负责提供好存储,开发人员不需要关注磁盘细节,只需要写一个申请单。

- 方便云服务商提供不同类型的,配置细节不需要开发者关注,只需要一个申请单。

- 动态创建 (opens new window),开发人员写好申请单后,供应商可以根据需求自动创建所需存储卷。

# 本地磁盘示例

不支持动态创建,需要提前创建好

apiVersion: apps/v1

kind: StatefulSet

metadata:

name: mongodb

spec:

replicas: 1

selector:

matchLabels:

app: mongodb

template:

metadata:

labels:

app: mongodb

spec:

containers:

image: mongo:5.0

imagePullPolicy: IfNotPresent

name: mongo

volumeMounts:

- mountPath: /data/db

name: mongo-data

volumes:

- name: mongo-data

persistentVolumeClaim:

claimName: mongodata

---

apiVersion: v1

kind: Service

metadata:

name: mongodb

spec:

clusterIP: None

ports:

- port: 27017

protocol: TCP

targetPort: 27017

selector:

app: mongodb

type: ClusterIP

---

apiVersion: storage.k8s.io/v1

kind: StorageClass

metadata:

name: local-storage

provisioner: kubernetes.io/no-provisioner

volumeBindingMode: WaitForFirstConsumer

---

apiVersion: v1

kind: PersistentVolume

metadata:

name: mongodata

spec:

capacity:

storage: 2Gi

volumeMode: Filesystem # Filesystem(文件系统) Block(块)

accessModes:

- ReadWriteOnce # 卷可以被一个节点以读写方式挂载

persistentVolumeReclaimPolicy: Delete

storageClassName: local-storage

local:

path: /root/data

nodeAffinity:

required:

# 通过 hostname 限定在某个节点创建存储卷

nodeSelectorTerms:

- matchExpressions:

- key: kubernetes.io/hostname

operator: In

values:

- node2

---

apiVersion: v1

kind: PersistentVolumeClaim

metadata:

name: mongodata

spec:

accessModes: ["ReadWriteOnce"]

storageClassName: "local-storage"

resources:

requests:

storage: 2Gi

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81